۵ کاری که نمیتوان در مرکز داده به صورت خودکار انجام داد

عنوان اصلی مقاله: Five Things You Can’t Automate In Your Data Center

تاریخ انتشار و نویسنده: By Christopher Tozzi, Jan 17, 2024

وبسایت منتشر کننده: Data Center Knowledge

وبسایت منتشر کننده: Data Center Knowledge

لینک اصلی مقاله

اتوماسیون مراکز داده یک موضوع داغ است، اما هنوز برخی از حوزههای کلیدی نیازمند دخالت انسانها هستند. در این مقاله خواهید دید که در حال حاضر کدام عملیات در مراکز داده در برابر اتوماسیون مقاومت دارند.

آلامی (Alami)

این راحت است که فرض نماییم اتوماسیون یا خودکارسازی در مراکز داده و فراتر از آن، دیگر هیچ مرزی ندارد. در دنیایی که به نظر میرسد هوش مصنوعی طیف بیحد و حصری از فرصتها را برای بهبود عملیات مراکز داده و شبکهها در اختیار ما گذاشته است و صنعت فناوری اطلاعات نیز این مفهوم را به طور کلی پذیرفته است که گردشهای کاری به قدری میتوانند خودکار شوند که ما به وضعیت نوآپس (NoOps) برسیم، شاید اینگونه وانمود شود که دیگر چیزی در مراکز داده وجود ندارد که نتوانیم آن را خودکار کنیم.

با این حال، واقعیت بسیار جدیتر است. در حالی که فناوریهای جدید پتانسیل زیادی برای خودکارسازی مراکز داده در بسیاری از زمینهها ایجاد کردهاند، جنبههای کلیدی عملیات در مراکز داده تا آیندهی نزدیک غیرقابل خودکارسازی خواهند بود.

در واقع، ماهیت فیزیکی مراکز داده ایجاب میکند که از برخی جهات، خودکارسازی تأسیسات و تجهیزات مرکز داده حتّی بیشتر از سایر انواع زیرساختها و محیطهای فناوری اطلاعات چالشبرانگیز است، از جمله سکوهای ابری عمومی، که در آن همهی آن چیزی که کاربران با آن در تعامل هستند، در نرمافزار تعریف میشود و بنابراین به راحتی با استفاده از راهحلهای مبتنی بر نرمافزار، خودکار میشوند.

برای اثبات این موضوع، در اینجا نگاهی به پنج جنبه از مراکز داده یا عملیات مرکز داده میاندازیم که هیچکس نباید این انتظار را داشته باشد که به این زودیها به طور کامل خودکار شوند.

-

استقرار سرورها

استقرار سرور در ابرهای عمومی، به سادگی و با استفاده از برخی از الگوهای «زیرساخت به شکل کد» برای تأمین منابع ابری به صورت خودکار انجام میشود.

با این حال، در یک مرکز داده امکان پیادهسازی این نوع خودکارسازی وجود ندارد، زیرا سرورهایی که شما مستقر میکنید سختافزار فیزیکی هستند. شخصی باید سرورها را نصب کند، آنها را به کابلهای برق و شبکه متصل نماید، از سرمایش مناسب آنها اطمینان حاصل کند و غیره.

به شکل نظری، رباتها قادر هستند بسیاری از کارهای استقرار سرورها در مراکز داده را به صورت خودکار انجام دهند. با این حال، برای انجام این کار به یک شکل مقرون به صرفه با استفاده از رباتها، باید در مقیاس وسیع عمل کرد. ضمن آنکه شما برای خودکارسازی چنین عملیاتی بدون کمک دست انسان، به استقرار سرورهایی نیاز دارید که به اندازهی کافی با یکدیگر همگون شده و کار با آنها قابل پیشبینی باشد. امروزه، بیشتر موارد استقرار سرورها چنین معیاری را برآورده نمیکنند.

حتماً دلیلی وجود دارد که ما هنوز تعداد کمی رُبات در مراکز داده میبینیم، در حالی که حداقل یک دهه است که در خصوص پتانسیل اتوماسیون رباتیک مراکز داده صحبت در میان است: در بیشتر موارد چنین کاری ممکن نیست. انتظار میرود استقرار سرورها حداقل برای یک آیندهی قابل پیشبینی دستی باقی بماند.

-

تعمیر و نگهداری سختافزار

به طریقی مشابه، نگهداری سختافزار سرورها پس از استقرار در داخل یک مرکز داده، وظیفهای نیست که در اکثر موارد قابلیت خودکارسازی داشته باشد. تعویض دیسکهای خراب، جایگزینی منابع تغذیه و کابلهای فرسوده و بهروزرسانی کارتهای شبکه، رویههایی معمول در اکثر مراکز داده هستند و تنها راه انجام آنها استفاده از نیروهای فنی انسانی است.

-

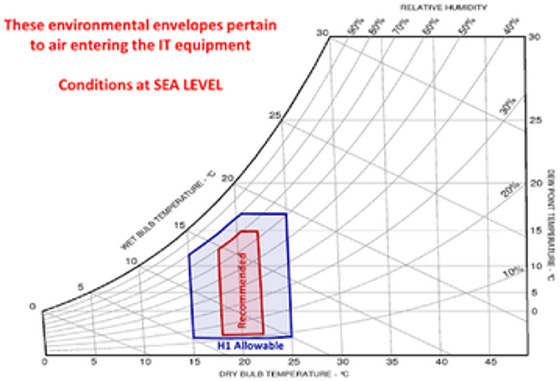

نصب و نگهداری تهویه

سامانههای سرمایش و چرخش هوا که از تجهیزات فناوری اطلاعات در برابر گرمای بیش از حد محافظت میکنند، جزء ضروری هر مرکز داده هستند؛ و همانند سرورها، سامانههای خنککننده نیز شامل اجزای فیزیکیای هستند که نیاز به نگهداری توسط انسان زنده دارند.

حسگرها و سامانههای پایش تهویه میتوانند از راه دور به خودکارسازی برخی از فرایندهای مرتبط با مدیریت تهویه کمک کنند؛ اما در نهایت، تعمیر و نگهداری تهویه کاری نیست که بتوان به راحتی آن را در مراکز داده خودکار نمود.

-

امنیت فیزیکی

امنیت فیزیکی مراکز داده حوزهی دیگری است که در آن سامانههای پایش قادر هستند به خودکارسازی برخی از وظایف مربوط به آن کمک کنند، در عین حالی که همچنان مداخلهی دستی انسانی برای پاسخ به مشکلات عمده ضروری است.

شما میتوانید از حسگرها برای ردیابی حرکت افراد در مرکز داده استفاده کنید و یا دستگاههای احراز هویت زیستسنجی یا بیومتریک (Biometric) را برای کنترل خودکار دسترسی فیزیکی به مرکز داده به کار بگیرید. با این حال، اگر یک مزاحم شناسایی شود، یا اگر سامانههای کنترل دسترسی خودکار به درستی کار نکردند، آنگاه به تعدادی نیروی امنیتی برای پاسخ به آن رویداد نیاز خواهید داشت.

-

بازیابی از فاجعه

در برخی موارد، روالهای بازیابی از فاجعه (Disaster recovery) را میتوان خودکار کرد. در واقع، خودکارسازی بازیابی از فاجعه برای صرفهجویی در زمان هنگام بازیابی دادهها یا برنامههای کاربردی پس از وقوع خرابی، یک امر حیاتی است.

با این حال، تنها در صورتی میتوانید بازیابی از فاجعه را به صورت خودکار انجام دهید که داراییهایی که نیازمند بازیابی هستند از نوع نرمافزاری باشند، ضمن آنکه باید زیرساخت کافی برای میزبانی از داراییهای بازیابیشده در دسترس داشته باشید.

اگر بازیابی مستلزم استقرار سختافزار جدید یا جایگزینی اجزای خراب باشد (که چنانچه مرکز داده دچار یک فاجعهی طبیعی شدهباشد و در آن برخی از سیستمها از کار افتاده باشند، احتمالاً همینطور خواهد بود)، باید به نیروی انسانی برای انجام دستی کارها تکیه نمایید.

محدودیتهای خودکارسازی مراکز داده

دلایل خوب بسیار زیادی وجود دارند تا نسبت به خودکارسازی عملیات در مراکز داده تا آخرین حد ممکن اقدام نماییم. اما بسیاری از جنبههای مدیریتی در مراکز داده، مناسب خودکارسازی نیستند.

حتّی در عصر هوش مصنوعی مولّد و فناوریهای رباتیک، تصوّر حذ ف کامل انسانها از مراکز داده به این زودیها دشوار به نظر میرسد.

منتشر شده در وبسایت دیتا سنتر نالج Data Center Knowledge

توسط کریستوفر توزی (Christopher Tozzi)، ۱۷ ژانویه ۲۰۲۴

برگردان توسط حامد معینفر

در شرکت مهندسین فناور پندار آریا – پنداریا

وبسایت منتشر کننده:

وبسایت منتشر کننده: