عنوان اصلی مقاله: The Eight Trends That Will Shape the Data Center Industry in 2023

تاریخ انتشار و نویسنده: By Rich Miller – Jan. 5, 2023

وبسایت منتشر کننده: Data Center Frontier

وبسایت منتشر کننده: Data Center Frontier

لینک اصلی مقاله

چه روندهایی در پیشِ روی صنعت مرکز داده در سال ۲۰۲۳ میباشند؟ سال جدید، سالی است که جریانهای متضاد، فعالیتهای تجاری در این بخش را در برابر یکدیگر همزمان محدود و تقویت میکنند. ما در اینجا روندهایی که معتقد هستیم بیشترین اهمیت را خواهند داشت، شرح میدهیم.

«قسمت دوم»

مطالعهی قسمت اول این مقاله

۴. حرکت به سوی طراحی بدون آب، هر کجا که امکانش وجود داشته باشد

یکی از تنشهای اصلی در توسعهی مراکز داده، مقدار زیاد آبی است که برای خنککردن تعدادی از آنها استفاده میشود. گرمای شدید و خشکسالیهای اخیر سطح معیار توقّعات را از سکّوهای محاسبات ابری با رشد بالا و توسعهدهندگان مراکز داده بالا بردهاند.

آدام سِلیپسکی (Adam Selipsky) مدیرعامل خدمات وب آمازون (AWS) میگوید: «پیشبینی میشود که طی چند سال آینده نیمی از جمعیت جهان در مناطق با تنش آبی زندگی کنند، بنابراین برای اطمینان از دسترسی تمام مردم به آب سالم، همهی ما باید راههای جدیدی را برای کمک به حفظ و استفادهی مجدد از این منبع ارزشمند ابداع کنیم.»

در بسیاری از مناطق، مراکز داده در حال حاضر از چیلرهای هواخنک استفاده میکنند که آب را در یک مدار بسته به گردش در میآورند و مصرف آب را به شدت کاهش میدهند. اما در مناطقی دیگر، مراکز داده همچنان بر سامانههای خنککنندهی تبخیری متّکی هستند که هرچند بسیار کارآمدند، اما به آب زیادی برای کارکرد خود نیاز دارند.

اکنون سکّوهای ابری بزرگ قول دادهاند که تراز آبی در مراکز دادهی خود را مثبت کنند و شروع به افشای اطلاعات بیشتر در مورد مصرف آب خود کردهاند. هرچند این یک پیشرفت است، اما تنها پاسخی است به فشار افکار عمومی و شکایتهای حقوقی که به دنبال دریافت اطلاعات مربوط به تأثیرات آبی مراکز داده در جوامع هستند. گوگل پس از سالها اصرار بر این ادعا که اطلاعات میزان مصرف آب مراکزش در برخی بازارها یک راز تجاری است، اخیراً دادههای مربوط به مصرف آب تأسیسات خود را به اشتراک گذاشته است که نشان میدهد در ناوگان مراکز داده آمازون در سال ۲۰۲۱، به میزان ۴٫۳ میلیارد گالن (۱۶٫۳ میلیون متر مکعّب) آب استفاده شدهاست که به طور متوسط برای هر مرکز داده روزانه ۴۵۰٬۰۰۰ گالن (۱٬۷۰۰متر مکعّب) آب محاسبه میشود.

این عدد بسیار بزرگی است و گوگل به دنبال آن بود تا این ارقام را در متن فعالیتهای تجاری ناشی از ارائهی خدمات خود قرار دهد، با تاکید بر این نکته که این ارقام معادل حجم آبی است که برای ۲۹ زمین گلف مصرف میشود (در مقایسه: بیش از ۱۱٬۰۰۰ زمین گلف در ایالات متحده وجود دارند).

دادههای منتشرشده توسط شرکت گوگل همچنین نشان داد که چگونه میزان مصرف آب میتوان در تناسب با آبوهوای هر منطقه و فناوری خنککننده مورد استفاده، متفاوت باشد. پردیس ابری گوگل در آیووا (Iowa) در سال ۲۰۲۱ بیش از ۱ میلیارد گالن (۳٫۸ میلیون متر مکعّب) آب مصرف کرد، در حالی که یک پردیس کوچکتر در آتلانتا (Atlanta) تنها تأثیر خالصی معادل ۱۳ میلیون گالن (۴۹٬۵۰۰ متر مکعّب) آب در همان سال داشت.

اورس هولزل (Urs Holzle)، معاون ارشد زیرساختهای فنّی در گوگل، در یک پست وبلاگ میگوید: «بهترین رویکرد در هر مکان به عوامل محلّی آنجا بستگی دارد و هیچ راهحل واحدی برای تمام شرایط وجود ندارد. در بسیاری از مکانها، آب کارآمدترین ابزار خنککننده است. خنککنندهی آب چنانچه به طور مسؤولانه استفاده شود، میتواند نقش مهمی در کاهش انتشار گازهای گلخانهای و کاهش تغییرات آبوهوایی ایفا کند. مراکز دادهی مجهز به سامانههای خنککنندهی آبی حدود ۱۰٪ انرژی کمتری مصرف میکنند و در نتیجه تقریبا ۱۰٪ سطح کمتری از کربن نسبت به بسیاری از مراکز دادهی از نوع هوا خنک منتشر میکنند. در سال 2021، خنککنندهی آب به ما کمک کرد تا ردپای کربنی مرتبط با مصرف انرژی در مراکز دادهی متعلق به خود را تقریباً معادل ۳۰۰٬۰۰۰ تُن دیاکسید کربن (CO2) کاهش دهیم.»

بله، شاید قضاوت در خصوص مصرف آب یک موضوع پیچیده باشد، اما از آنجایی که مناطق بیشتری با خشکسالی و کمبود آب مواجه هستند (مانند حوضهی آبریز رودخانهی کلرادو (Colorado Basin))، مراکز داده با فشار فزایندهای برای کاهش تأثیر آبی خود مواجه خواهند شد. این بخش از صنعت توانایی اثباتشدهای برای حفظ منابع از طریق بهکارگیری نوآوری و ایجاد نظم در عملیات، از خود نشان دادهاست، چنانچه در جریان موفقیت خیرهکنندهی صنعت مراکز داده در افزایش بهرهوری انرژی مشاهده شد، که با وجود یک دهه رشد تصاعدی در توان محاسباتی مراکز داده بین سالهای ۲۰۱۰ تا ۲۰۲۰، مصرف برق این صنعت تنها ۴ درصد افزایش یافت و ۶۰ میلیارد دلار صرفهجویی به همراه داشت.

انقلاب بهرهوری انرژی پاسخی به فشار عمومی و ترس از مقررات بود. انتظار میرود موج مشابهی از نوآوری در پرداختن به صرفهجویی در مصرف آب در سالهای آینده، از سال ۲۰۲۳ آغاز شود.

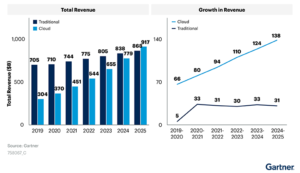

۵. برای اَبَرمقیاسهای گرسنه، امسال سالی برای هضم است

هر کسی که فعالیت مراکز داده در سال گذشته را دنبال کردهباشد، نباید از اینکه بهرهبرداران اَبَرمقیاس ممکن است فضای کمتری را در سال ۲۰۲۳ اجاره کنند تعجب نماید. این شرکتها در نیمهی اول سال ۲۰۲۲ مقادیر تاریخی ظرفیت مرکز داده در اختیار گرفتند تا در بحبوحهی گسترش نگرانیها مبنی بر کُندشدن تحویل ظرفیتهای جدید در آینده با توجه به اختلالات زنجیرهی تأمین، توسعهی زیرساختهای خود را سرعت بخشند.

بسیاری از این معاملات بزرگ نشاندهندهی پیشاجارههایی بودند که در آنها مشتریان بزرگ اقدام به خرید تمام یک ساختمان در حالی که همچنان در مرحلهی طراحی و ساخت بود، میکردند. از آنجایی که شرکتهای اَبَرمقیاس برای قطعیکردن ظرفیت موجود در اختیار خود با یکدیگر در حال مبارزه بودند، آنها به وضوح در حال پیشخرید نیاز آتی خود نیز بودند. اکنون این امر اجتنابناپذیر است که در برخی مواقع بازار اجاره کُند شود تا این شرکتها فرصت هضم ظرفیتی را که قبلاً خریداری کردهاند، پیدا نمایند.

خطوط کلی نتایج حاصل از این رخداد را میتوان در تصمیم شرکت مِتا (Meta) برای توقف ساخت تعدادی از پروژههای مرکز دادهی خود مشاهده کرد تا بتواند تأسیسات جدید خود را با یک تغییر معلّق در طراحی که بر هوش مصنوعی (AI) متمرکز است، «بازبینی» نماید. گوگل نیز برنامههای توسعهای خود را تعدیل نموده و طبق گزارشها پروژهی مرکز دادهی خود در بازار مینیاپولیس (Minneapolis) را به حال خود رها کردهاست.

همچنین تغییراتی در توئیتر (Tweeter) که تا همین اخیراً در سال ۲۰۲۱ یک مصرفکنندهی بزرگ برای بازار عمدهفروشی فضاهای مرکز داده بود، رخ دادهاست. مدیر عامل جدید آن ایلان ماسک (Elon Musk) فعلاً در وضعیت کاهش هزینهها قرار دارد و بنا به گزارشها اخیراً یکی از مراکز دادهی این شرکت را که در بازار ساکرامنتو (Sacramento) قرار دارد، تعطیل کردهاست.

لیگت (Liggett) میگوید: «ما شاهد عقبنشینی جزئی در سرعت تقاضای این کاربران بزرگ هستیم. این میتواند منجر به بروز برخی نوسانات در بازار شود و میتواند به این معنی باشد که ممکن است تا چند ماه رشد قابل توجهی در بازار مشاهده نشود. با توجه به تقاضای قابل توجهی که در سال ۲۰۲۲ شاهد بودیم، معتقدیم این کاهش سرعت موقتی خواهد بود.»

بازار اَبَرمقیاسها قبلاً نیز در سال ۲۰۱۹ پس از ثبت یک رکورد در بازار اجاره در سال ۲۰۱۸، یک چرخهی هضم را طی کرد. اما این تنها یک وقفهی موقتی بود، چنانچه مشاهده شد که همین صنعت در سالهای ۲۰۲۰ و ۲۰۲۱ به وضعیت پررونق اجاره بازگشت.

۶. رونق در بازارهای ثانویه از ابر تا لبه ادامه خواهد یافت

امسال ما تاکید خود را بر رشد مراکز داده در بازارهای ثانویه دو برابر میکنیم، روندی که با ظهور کمبود برق در بازارهای اولیه شتاب بیشتری گرفتهاست. این شامل ظهور بازارهای فرعی بیشتری در اطراف شاهراههای مراکز دادهی موجود، و همچنین پروژههای عظیم در مناطق جدیدی که برق و زمین کافی برای پشتیبانی از نسل جدید پردیسهای عظیم (MegaCampuses) در اختیار دارند، میشود.

طبق معمول، ویرجینیای شمالی بارزترین نمونه از این روند خواهد بود. شهرهای گِینسویل (Gainesville) و کاتارپین (Catharpin) در شهرستان پرنس ویلیام کانون تمرکز بیش از 20 میلیون فوت مربع (۱٫۹ میلیون متر مربع) توسعهی مرکز داده توسط کامپس دیتاسنترز (Compass Data Centers)، کیوتیاس دیتاسنترز (QTS Data Centers)، انتیتی گلوبال دیتاسنترز آمریکا (NTT Global Data Centers Amerika) و کورِسکیل دیتاسنترز (Corscale Data Centers) هستند.

در سراسر منطقهی پوتاماک (Potomac)، اَلایند دیتاسنترز (Aligned Data Centers) قصد دارد حداقل 3.3 میلیون فوت مربع (۳۰۷ هزار متر مربع) فضای مرکز داده را در آدامزتاون ایالت مریلند (Adamstown MD) در شهرستان فرِدِریک (Frederick County) بسازد، و این تنها اولین مشتری اعلامشدهی اَبَرپردیس کوانتوم لوپهول (Quantum Loophole) میباشد.

روند مشابهی در حومهی شیکاگو مشاهده می شود، جایی که مزارع بزرگ سرور در دیکالب (DeKalb)، ماونت پراسپکت (Mount Prospect)، نورتلیک (Northlake) و ایتاسکا (Itasca) در حال ساخت هستند.

اِرنست پوپِسکو (Ernest Popescu)، رئیس بخش جهانی انتخاب محلهای ساخت در آیرون ماونتن دیتاسنترز (Iron Mountain Data Centers) مینویسد: «فرصتها فراوان است، اما اکنون بیشتر دنبال رشد در بازارهای سطح دو هستیم. در ایالات متحده، ما شاهد توسعهی بیشتر مراکز داده در شهرهایی مانند دِنور (Denver)، پیتسبورگ (Pittsburgh)، دیترویت (Detroit)، سالت لیک سیتی (Salt Lake City) و تامپا (Tampa) هستیم که همگی بازارهایی هستند که با عنوان ’شهرهای فوتبالدوست‘ شناخته میشوند.»

ریا ویلیامز (Rhea Williams)، انتخابکنندهی اصلی محلهای ساخت برای اوراکل کلاود (Oracle Cloud)، در میزگرد اخیر دیتاسنتر فرانتیر (DCF) گفت: «محدودیتهای حاضر در مناطق اصلی به افزایش تقاضا در بازارهای ’سطح دوم‘ ادامه خواهد داد. استفادهی بیشتر از تجهیزات شخصی و خانگی که باعث افزایش مصرف و تولید دادههای بیشتر میشود، نیاز به افزایش سطح پوشش را از نقطهنظر تأخیر (Latency) افزایش خواهد داد. چه آن را سطح دوم بنامید یا لبه، همه چیز اکنون به رشد اشاره دارد.»

۷. مراکز دادهی بیشتری از «تولید برق در محل» استقبال میکنند

نیرو حوزهی دیگری است که در آن شاهد پژواک پیشبینیهای سال گذشتهی خود هستیم، جایی که دیتاسنتر فرانتیر (DCF) پیشبینی کرد که دادهها و انرژی ارتباطات عمیقتری را با یکدیگر ایجاد خواهند کرد. صحّت این پیشبینی با قطعیت ثابت شدهاست، اما در پیشبینی امسال ما زاویهی دید خود را محدودتر میکنیم. در سال ۲۰۲۳، شاهد پروژههای مرکز دادهی بیشتری خواهیم بود که در خود تولید انرژی در محل را نیز شامل میشوند تا امکان گسترش در بازارهای دارای محدودیت شبکهی تأمین برق را فراهم شود.

نمونهی اولیهی این روند در ایرلند مشاهده میشود، جایی که مایکروسافت قصد دارد یک نیروگاه گازی عظیم ۱۷۰ مگاواتی بهعلاوهی ۲۱ نیروگاه دیزلی کوچکتر احداث نماید. این تصمیم پس از آن اتخاذ شد که بهرهبردار شبکهی برق ایرلندی ایرگرید (EirGrid) به طور مؤثر سقف انشعابات برق را برای ساخت مراکز داده جدید در بازار دوبلین محدود کرد.

راهبردهای مشابهی میتواند در شهرستان لودون (Loudoun) در ویرجینیای شمالی ظاهر شود، جایی که سقف انشعابات جدید برق از شرکت دومینیون انرژی (Dominion Energy) به دلیل محدودیتها در شبکهی محلی انتقال برق با ظرفیت بالا، به شدت تا سال ۲۰۲۶ محدود خواهد شد.

در مقیاس کوچکتر، امسال شاهد ورود راهحلهای اِدج سنترز (Edge Centers) به بازار ایالات متحده خواهیم بود که تخصّص آن در راهاندازی مراکز دادهی لایهی لبه با پشتیبانی از انرژی خورشیدی در بیرون از شبکهی سراسری برق میباشد. این شرکت شبکهای از این تأسیسات را در آسیا ساختهاست که شامل سایتهایی در استرالیا، مالزی، ویتنام، تایلند، اندونزی و فیلیپین میشود.

به گفتهی کارشناسان وِرتیو (Vertiv)، ما احتمالاً شاهد تمرکز بیشتر بر روی استفاده از سلولهای سوختی هیدروژنی برای تأمین انرژی پشتیبان و حتی اوّلیه نیز خواهیم بود.

وِرتیو در پیشبینیهای خود برای سال ۲۰۲۳ میگوید: «این سلولهای سوختی در ابتدا مانند یک مولّد عمل میکنند و تنها بار لحظهای را پشتیبانی میکنند و در نهایت نوید عملکرد پایدار یا حتی مداوم را میدهند.»

هر دو شرکت مایکروسافت و اکوئینکس پروژههایی برای آزمایش تولید انرژی مبتنی بر هیدروژن در شبکهی عملیات برق خود دارند. میتوان انتظار داشت که در سال ۲۰۲۳ شاهد تمرکز شتابان بر روی این فناوری باشیم.

۸. بازاندیشی در ریزش مشتریان: یک تهدید به یک فرصت تبدیل میشود

ارائهدهندگان فضاهای مرکز داده همواره مقولهی ریزش مشتریان را به عنوان یک دشمن تلقی کردهاند. اما با ورود صنعت به دورهای از محدودیتها در ظرفیت قابل ارائه، نگرشها نسبت به ریزش، که در آن مستاجران فضای مرکز داده را پس از پایان دورهی اجارهی خود خالی میکنند، در حال تغییر است.

هنگامی که یک مشتری مرکز داده را ترک میکند، ارائهدهندگان باید فضای خالیشده را که دیگر درآمدی ایجاد نمیکند پُر نمایند. در محیطی که ظرفیت جدید کمیاب است، فضای موجود ارزشمندتر میشود.

چارلز مایرز (Charles Meyers)، مدیرعامل اکوئینکس، در یک کنفرانس خبری اخیر دربارهی درآمدهای شرکت گفت: «ما حتّی میبینیم مشتریانی که قبل از این قصد داشتند از بهرهبرداری از فضاهای در اختیار خود انصراف دهند، اکنون برنامهریزی خود را برعکس نمودهاند. حصول اطمینان از در اختیار داشتن فضای پیشین، تحت همان شرایط قبلی یا نزدیک به آن شرایط، برای آنها یک تصمیم راهبردی است. ما به همین دلایل شاهد مطلوبیت بیشتر در مقولهی ریزش مشتریان هستیم.»

تغییر در شرایط عرضه، پویایی طولانیمدت در قیمتگذاری فضاهای مرکز داده را نیز تغییر دادهاست. شرکت دیجیتال ریالیتیز پاور (Digital Realty’s Power) که میگوید نرخ فضاهای هممکان ۱۰٪ تا ۱۵٪ افزایش یافتهاست و خاطرنشان میکند که ارائهدهندگانی که فضاهای خالی در اختیار دارند به ویژه در اَشبورن (Ashburn) در موقعیت چانهزنی مناسبی قرار گرفتهاند، عنوان میکند: «ما همچنان شاهد بهبود قدرت قیمتگذاری در سرتاسر سکّوهای خود هستیم.»

این شرکت میگوید: «اما از هماکنون تا (۲۰۲۶)، عرضهی کمتری در بزرگترین بازار پرتقاضا وجود خواهد داشت. این بدان معناست که آونگ قدرت قیمتگذاری در حال برگشت به سمت و به نفع ما است.»

ریچ میلر (Rich Miller)

من در مورد مکانهایی مینویسم که اینترنت در آن محلها زندگی میکند و داستان مراکز داده و افرادی که آنها را میسازند بیان میکنم. من دیتاسنتر نالِج (Data Center Knowledge) را که سایت خبری پیشرو در صنعت مرکز دادهاست، تأسیس کردهام. من اکنون در حال پایش آیندهی محاسبات ابری در دیتاسنتر فرانتیر (Data Center Frontier) هستم.

منتشر شده در وبسایت Data Center Frontier

برگردان توسط حامد معینفر

در شرکت مهندسین فناور پندار آریا – پنداریا

وبسایت منتشر کننده: LinkedIn

وبسایت منتشر کننده: LinkedIn