خنکسازی مستقیم تراشهها: هر آنچه که بهرهبرداران مرکز داده باید بدانند

عنوان اصلی مقاله: Direct-to-Chip Cooling: Everything Data Center Operators Should Know

تاریخ انتشار و نویسنده: By Christopher Tozzi, Nov 27, 2023

وبسایت منتشر کننده: Data Center Knowledge

وبسایت منتشر کننده: Data Center Knowledge

لینک اصلی مقاله

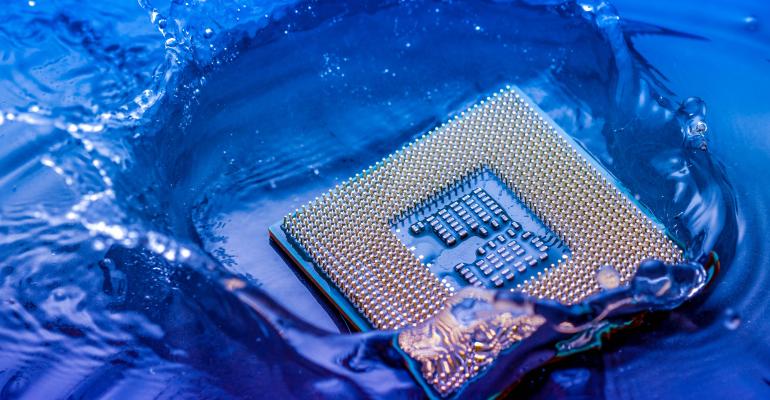

خنکسازی مستقیم تراشهها در حال تبدیلشدن به یک راهبرد سرمایشی جذاب در مراکز داده است.

ناتاپُل شریتُنگکوم (Nattapol Sritongcom) / آلامی (Alami)

آن دسته از سامانههای خنککننده که هستهی مرکزی تولید حرارت را هدف قرار میدهند، قادر هستند گرما را به شکل مؤثّرتری دفع نمایند. به همین دلیل است که خنکسازی مستقیم تراشهها یا خنکسازی مستقیم بر تراشه (Direct-to-chip cooling) در حال تبدیلشدن به یک راهبرد سرمایشی جذّاب در مراکز داده هستند.

هرچند که خنککنندههای مستقیم بر تراشه قادرند داغترین اجزای یک سرور را هدف قرار دهند، با این حال باید توجه داشت که هزینهی بالا و خطر خرابی این نوع سامانهها به این معنی است که این روش نمیتواند همواره یک راهحل مناسب تلقّی شود.

برای آشنایی با روش «خنکسازی صفحه سرد مستقیم بر تراشه (Direct-to-chip cold plate cooling)» و اینکه چگونه کار میکند و چرا ممکن است روش مناسبی برای سرمایش سرورهای مرکز داده شما باشد یا نباشد، به خواندن این متن ادامه دهید.

خنکسازی صفحه سرد مستقیم بر تراشه چیست؟

خنکسازی صفحه سرد مستقیم بر تراشه، عملِ به گردش درآوردن مایع خنککننده از میان یک صفحه (یا همان «صفحهی سرد») است که در تماس مستقیم با منابع اصلی حرارت، از جمله واحدهای پردازندهی مرکزی (CPUs) قرار گرفتهاست. مایع، گرما را از اجزاء دریافت کرده و به طور مؤثر تجهیزات را خنک میکند.

از آنجایی که روش خنکسازی مستقیم تراشهها به سامانههای سرمایشی این اجازه را میدهد تا قسمتهایی از تجهیزات فناوری اطلاعات (IT) را که بیشترین گرما را تولید میکنند هدف قرار دهند، روشی سریعتر و کارآمدتر برای پیشگیری از گرمشدن بیش از حد دستگاهها است.

خنککنندهی مستقیم بر تراشه چگونه کار میکند؟

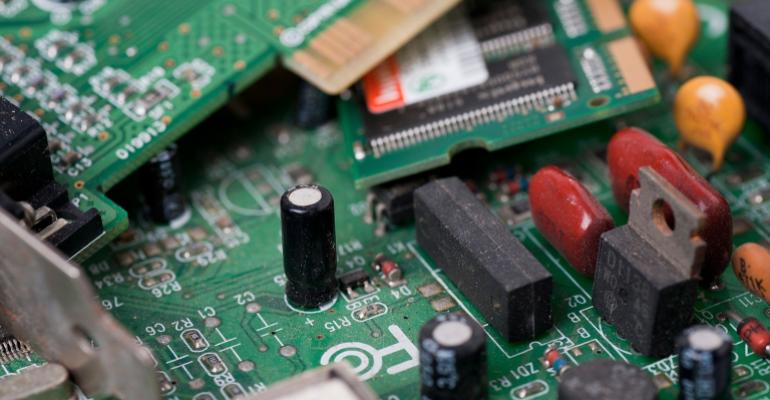

سامانههای خنککنندهی مستقیم بر تراشه به چندین اجزاء نیاز دارند:

– مایع خنککننده، که معمولاً یک سیّال دیالکتریک (Dielectric fluid) میباشد و برای کاربرد خنکسازی مستقیم بر تراشه شخصیسازی شدهاست.

– صفحهی سرد، که مایع بتواند از داخل آن عبور کند.

– پمپ، که مایع را در مدار به حرکت در میآورد.

– مادهی رابط حرارتی، که به انتقال گرما از منبع به صفحهی سرد کمک میکند.

این اجزاء در کنار هم به روشی نسبتاً ساده کار میکنند؛ حرارت حاصل از پردازندهها و یا سایر منابع گرمایی به صفحهی سرد منتقل شده و سپس توسط مایعی که در گردش است از آن ناحیه خارج میشود.

مزایای خنکسازی مستقیم بر تراشه

مزیت اصلی خنکسازی مستقیم تراشهها این است که گرما را سریعتر خارج کرده و انرژی کمتری نسبت به سامانههای خنککنندهی سنّتی که در طراحیهای مرکز داده دیده میشوند، مصرف میکند؛ مانند سامانههایی که هوای سرد را از میان رَکهای سرور به گردش در میآورند.

سامانههای سنّتی سرمایش هوا، به جای هدف قرار دادن دقیق منابع حرارتی، هوای سرد را به سمت کل یک مجموعه از تجهیزات پرتاب میکنند. بخش زیادی از این هوا از روی اجزایی که منابع اصلی تولید گرما نیستند، عبور میکند، مانند رابطهای شبکه (Network interfaces) و بخشهای بیرونی بُردهایاصلی (Mainboards)، و این بدان معنا است که هوای خنک به طور مؤثّری در حال هدر رفتن است.

در مقابل، سامانههای خنککنندهی مستقیم بر تراشه قادر هستند مشخصاً آن اجزای خاصی که گرما تولید میکنند را خنک نمایند. در نتیجه گرمای بیشتری را با انرژی کمتری دفع مینمایند که این از منظر پایدارپذیری (Sustainability) (چرا که مصرف انرژی کمتر، خروجی کربن مرکز داده را کاهش میدهد) و همچنین از دیدگاه اطمینانپذیری (Reliability)، یک برد محسوب میشود. هر چه سامانههای سرمایشی در دفع گرما بهتر عمل کنند، خطر خرابیهای فناوری اطلاعات با ریشهی گرمای بیش از حد نیز کاهش مییابد.

چالشهای خنکسازی مستقیم بر تراشه

در حالی که خنکسازی مستقیم بر تراشه مزایای متعددی به همراه دارد، این فناوری با چالشها و محدودیتهایی نیز روبرو است:

هزینه: پیادهسازی و نگهداری سامانههای هوای سرد تقریباً همیشه هزینهی کمتری نسبت به سامانههای مستقیم بر تراشه دارند؛ چرا که نیازمند قطعات گرانتر و پیچیدهتر است.

خطر نشت: این احتمال وجود دارد که سیّالات داخل سامانههای مستقیم بر تراشه نشت پیدا کنند. نشت معمولاً تهدیدی بزرگ برای تجهیزات فناوری اطلاعات محسوب نمیشود، چرا که این سیّالات رسانا نیستند. با این وجود هر گونه نشت، حداقل موجب از کار افتادن سامانهی خنککننده و بروز گرمای بیش از حد میشود. آن دسته از بهرهبرداران مرکز داده که نگران خطرات ناشی از نشت سیّال هستند ممکن است خنککنندههای غوطهور (Immersion cooling) را انتخاب نمایند؛ از آنجا که در چنین سامانههایی دیگر هیچ سیّالی در صفحات کوچک و شکننده در جریان نیست، کمتر مستعد نشتی هستند.

اثرات زیستمحیطی: سیّالاتی که در مدارهای سامانههای مستقیم بر تراشه جریان دارند، اغلب با محیط زیست سازگار نیستند؛ لذا در ارتباط با این سامانهها همواره مخاطراتی از نوع آلودگی وجود دارند.

اجزای خنکنشده: از آنجایی که سامانههای مستقیم بر تراشه فقط منابع اصلی گرما را خنک میکنند، این خطر وجود دارد که سایر بخشهای سرور، مانند دیسکهای سخت، بیش از حد داغ شوند. این دلیل دیگری است که چرا برخی از بهرهبرداران مرکز داده تمایل به بهکارگیری خنککنندههای غوطهور که تمام قسمتهای یک سامانه را خنک میکنند، دارند.

اگر نگران هزینههای پیشراهاندازی هستید، سامانههای سنّتیتر خنککنندهی هوا راهحل بهتری نسبت به خنککنندههای مستقیم بر تراشه هستند. البته توجه داشته باشید که در دراز مدت، خنکسازی مستقیم تراشهها میتواند به دلیل مصرف انرژی کمتر، نسبت به خنکسازی هوا بیشتر مقرونبهصرفه باشد. البته این نکته نیز وجود دارد که سامانههای خنککنندهی هوا مستعد مخاطرات ناشی از نشتی نیستند.

در عین حال، خنککنندههای غوطهور به طور کلی مخاطرات کمتری دارند، هرچند که معمولاً اجرای آنها گرانتر از خنککنندههای مستقیم بر تراشه است. البته ممکن است برای زیرساختهای مقیاس بزرگ (یعنی آنهایی که شامل صدها یا هزاران سرور هستند)، هزینهی نصب خنککنندههای غوطهور تقریباً مشابه یا حتی کمتر از خنککنندههای مستقیم بر تراشه که برای راهاندازیهای مقیاس کوچکتر مناسب هستند، باشد.

از کجا میتوان راهحلهای خنکسازی مستقیم بر تراشه یافت

خنکسازی مستقیم بر تراشه وارد دورهی اوج خود شده است و یک مؤلفهی اصلی از بازار در حال رشد خنککنندههای مبتنی بر مایع در مراکز داده که شامل سامانههای خنککنندهی غوطهور نیز میشود، میباشد. در حال حاضر تعدادی از سازندگان، از جمله برخی از استارتآپهایی که در گذشته آنها را پوشش دادهایم، راهحلها و محصولاتی در این دسته ارائه میدهند.

با این وجود، از آنجا که سامانههای خنککنندهی صفحه سرد مستقیم بر تراشه باید برای انواع خاصی از تجهیزات که از آنها پشتیبانی میکنند طراحی شوند، این امکان وجود ندارد که بیرون بروید و این محصول را از قفسهی یک فروشگاه بخرید. شما نیاز دارید با فروشندهای کار کنید که قادر است یک سامانه را بر اساس مشخصات خاص مرکز داده و سرورهای مورد نظر شما طراحی نماید.

منتشر شده در وبسایت دیتا سنتر نالج Data Center Knowledge

توسط کریستوفر توزی (Christopher Tozzi)، ۲۷ نوامبر ۲۰۲۳

برگردان توسط حامد معینفر

در شرکت مهندسین فناور پندار آریا – پنداریا

وبسایت منتشر کننده:

وبسایت منتشر کننده:

وبسایت منتشر کننده:

وبسایت منتشر کننده: