پایان قانون مور چه معنایی برای صنعت مرکز داده دارد؟

عنوان اصلی مقاله: What Does the End of Moore’s Law Mean for the Data Center Industry?

تاریخ انتشار و نویسنده: by Christopher Tozzi, May 26, 2023

وبسایت منتشر کننده: Data Centre Dynamics Ltd (DCD)

وبسایت منتشر کننده: Data Centre Dynamics Ltd (DCD)

لینک اصلی مقاله

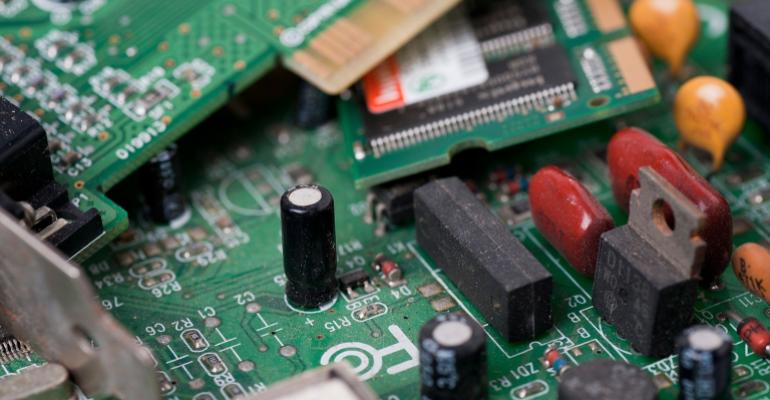

شاید قانون مور (Moor’s Law) هنوز نمرده باشد، اما مطمئناً در بستر مرگ است. در اینجا به چگونگی تاثیر کاهش سرعت رشد قدرت محاسباتی بر صنعت مرکز داده میپردازیم.

چنانچه بیخبر بودهاید، اکنون بدانید که قانون مور – با این فرض که قدرت محاسباتی در طول زمان به طور پیوسته افزایش مییابد – دیگر مرده است، یا در بهترین حالت ممکن به آرامی در حال مرگ است. دیگر همچون دهههای گذشته ظرفیت پردازشی تراشههای رایانهای با سرعت بالا در حال افزایش نیست.

این تغییر چه معنایی برای مراکز داده خواهد داشت؟ به طور بالقوه، به مقدار زیاد! برای مشاهدهی اینکه چگونه کُندشدن رشد توان محاسباتی میتواند بر صنعت مرکز داده تأثیرگذار باشد، به خواندن این نوشتار ادامه دهید.

قانون مور چیست و چرا مرده است؟

قانون مور که به پشتوانهی گوردون مور (Gordon Moore) یکی از بنیانگذاران اینتل (Intel) که این مفهوم را در سال ۱۹۶۵ مطرح کرد نامگذاری شده است، این اصل را بیان میکند که تعداد ترانزیستورهایی که مهندسان قادر هستند در داخل تراشههای رایانهای قرار دهند، تقریباً هر دو سال یکبار دو برابر می شود. با همین نسبت، قدرت محاسباتی تراشههای ردهی متوسط نیز باید با سرعتی مشابه افزایش یافته و هزینههایی که کسبوکارها برای بهدستآوردن توان پردازشی میپردازند کاهش یابد.

برای چندین دهه، قضیهی مور در اکثر موارد دقیق بود. ظرفیت محاسباتی تقریباً با سرعتی که او پیشبینی کردهبود افزایش یافت.

اما این قاعده دیگر جاری نیست. اگرچه ممکن است برای اینکه بگوییم قانون مور قطعاً مرده است خیلی زود باشد، با این وجود دلایلی وجود دارد که باور داشتهباشیم که اکنون به محدودیتهای فیزیکی در سیپییوهای (CPUs) بر پایهی سیلیکون برخورد کردهایم. بدون یک جایگزین عملیاتی، مهندسان دیگر قادر نیستند قدرت محاسباتی تراشهها را به همان سرعتی که در سالهای گذشته انجام میدادند، افزایش دهند.

بدون تردید این امکان وجود دارد که افرادی با هوش بالا راههایی را برای دور زدن محدودیتهای فعلی سیلیکونها پیدا کنند، یا اینکه بالاخره محاسبات کوانتومی عملیاتی شود و زمین بازی پیرامون توانهای محاسباتی را به طور کامل تغییر دهد. اما در حال حاضر دادهها نشان میدهند که نرخ افزایش توان پردازشی در حال کاهش است، بدون هیچ نشانهی روشنی مبنی بر اینکه این روند به زودی تغییر خواهد کرد.

قانون مور و مراکز داده

این واقعیت که ظرفیتهای سیپییوها با سرعت پیشین در حال رشد نیستند، میتواند چندین پیامد عمیق برای مراکز داده به همراه داشته باشد.

مراکز دادهی بیشتر

شاید واضحترین تاثیر آن این باشد که چه بسا ما شاهد ساخت مراکز دادهی بیشتری خواهیم بود.

حتّی اگر قانون مور نیز درست باشد، به احتمال زیاد این اتفاق در هر صورت خواهد افتاد. تقاضا برای خدمات دیجیتال مدّتها است که از افزایش توان پردازشی پیشی گرفتهاست، به این معنی که شرکتها مجبور شدهاند زیربنا و به قولی ردّپای زیرساختهای فناوری اطلاعات خود را گسترش دهند، حتّی با این وجود که توان پردازشی تکتک سرورها در این زیرساختها در حال افزایش بودهاست.

اما در دنیای پَسا قانون مور، ما به مراکز دادهی به مراتب بیشتری نیاز خواهیم داشت. اگر سرورها دیگر سال به سال قدرتمندتر نشوند، تنها راه برای پاسخگویی به افزایش تقاضای کاربران، استقرار سرورهای بیشتر خواهد بود که به معنای ساخت مراکز دادهی بیشتر است.

چالشهای پایدارپذیری در مراکز داده

افزایش تعداد کل مراکز داده چالشهای فعلی مرتبط با قابلیت پایدارپذیری در مراکز داده را تشدید خواهد کرد. نصب سرورهای بیشتر به معنی نرخهای بالاتر مصرف انرژی است، به خصوص اگر تعداد ترانزیستورها در هر تراشه ثابت بماند.

گمان میرود این بدان معنا باشد که جذابیت و مزیّت آن دسته از ارائهدهندگان خدمات مراکز داده که قادر هستند از منابع انرژی پاک بهره ببرند، بیشتر خواهد شد. تاثیر فناوریهای نسل بعدی (Next-generation) مراکز داده، از جمله خنککنندههای غوطهور (Immersion Cooling) نیز که قادر هستند ردّپای کربنی تأسیسات مراکز داده را کاهش دهند، به همین صورت خواهد بود.

شرکتهای بیشتری وارد بازار تراشهها خواهند شد

برای چندین دهه، تعداد نسبتاً کمی از سازندگان – یعنی اینتل و اِیاِمدی (AMD) – بر بازار تراشههای رایانهای که در سرورهای مصرفی نصب میشدند تسلّط داشتند. این شرکتها قادر بودند توان پردازشی را بهطور پیوسته افزایش دهند که همین موضوع به سایر کسبوکارها انگیزهی کمی برای ورود به بازی ساخت تراشهها میداد.

اما این موضوع در سالهای اخیر تغییر کردهاست، زیرا شرکتهایی مانند اِیدبلیواِس (AWS) شروع به ساخت تراشههای اختصاصی خود کردهاند و چه بسا منسوخشدن قانون مور چنین کسبوکارهایی را به سرمایهگذاری بیشتر در فناوریهای طراحی و ساخت سیپییوها سوق دهد. دلیل این امر این است که آنها به دنبال راههای جدیدتر و بهتری برای افزایش کارایی در تراشهها هستند، بهویژه در زمینهی موارد استفادهای خاص که پردازندهها را برای آن کارها مستقر میکنند.

به عبارت دیگر در دنیایی که سیپییوهای عمومی بر خلاف گذشته سال به سال قدرتمندتر و ارزانتر نمیشوند، شرکتها انگیزهی بیشتری برای توسعهی سیپییوهای خاص خود پیدا میکنند که برای موارد استفادهای که برایشان اهمیت دارد، بهینهسازی شدهاند.

بهینهسازی بارهای کاری اهمیت پیدا خواهد کرد

کاهش بارهای کاری (Workload) مصرفی سیپییوها همواره یک حرکت هوشمندانه برای شرکتهایی بوده است که میخواهند در هزینههای میزبانی خود صرفهجویی کنند. اما در دنیای پس از قانون مور، اهمیت بهینهسازی بارهای کاری بسیار بیشتر از اکنون خواهد شد.

این بدان معنا است که گمان میرود ما شاهد انتقال بارهای کاری بیشتری به کانتینرها باشیم. چه بسا بازار فینآپس (FinOps) و بهینهسازهای هزینههای ابری نیز رونق خواهند گرفت، زیرا کسبوکارهای بیشتری به دنبال راهبردهایی برای بهحداکثررساندن کارایی بارهای کاری خود خواهند بود.

نتیجهگیری

صنعت مرکز داده در جهانی رشد کرد که در آن قدرت تراشههای رایانهای همواره در حال افزایش و قیمت آنها در حال کاهش بودهاست. اما آن جهان دیگر از دنیا رفته است! ما در عصر پس از قانون مور یا نزدیک به آن زندگی می کنیم.

چه بسا در نتیجهی این تحوّل شاهد مراکز دادهی بیشتر، سیپییوهای متنوّعتر با اهداف خاص و فشارهای بیشتر بر کسبوکارها برای بهینهسازی مراکز دادهی خود باشیم. ارائهدهندگان خدمات مراکز داده و مشتریان آنها باید خود را با وضعیت جدید وفق دهند، یا همچنان به این امید که در نهایت انقلاب کوانتومی به نتیجه خواهد رسید و به طرز مضحکی قدرت محاسباتی را ارزان خواهد کرد منتظر بمانند، اگرچه گمان میرود این یک راهبرد برنده نباشد.

منتشر شده در وبسایت Data Centre Dynamics Ltd (DCD)

۲۶ مه ۲۰۲۳، توسط کریستوفر توزی (Christopher Tozzi)

برگردان توسط حامد معینفر

در شرکت مهندسین فناور پندار آریا – پنداریا

وبسایت منتشر کننده:

وبسایت منتشر کننده:

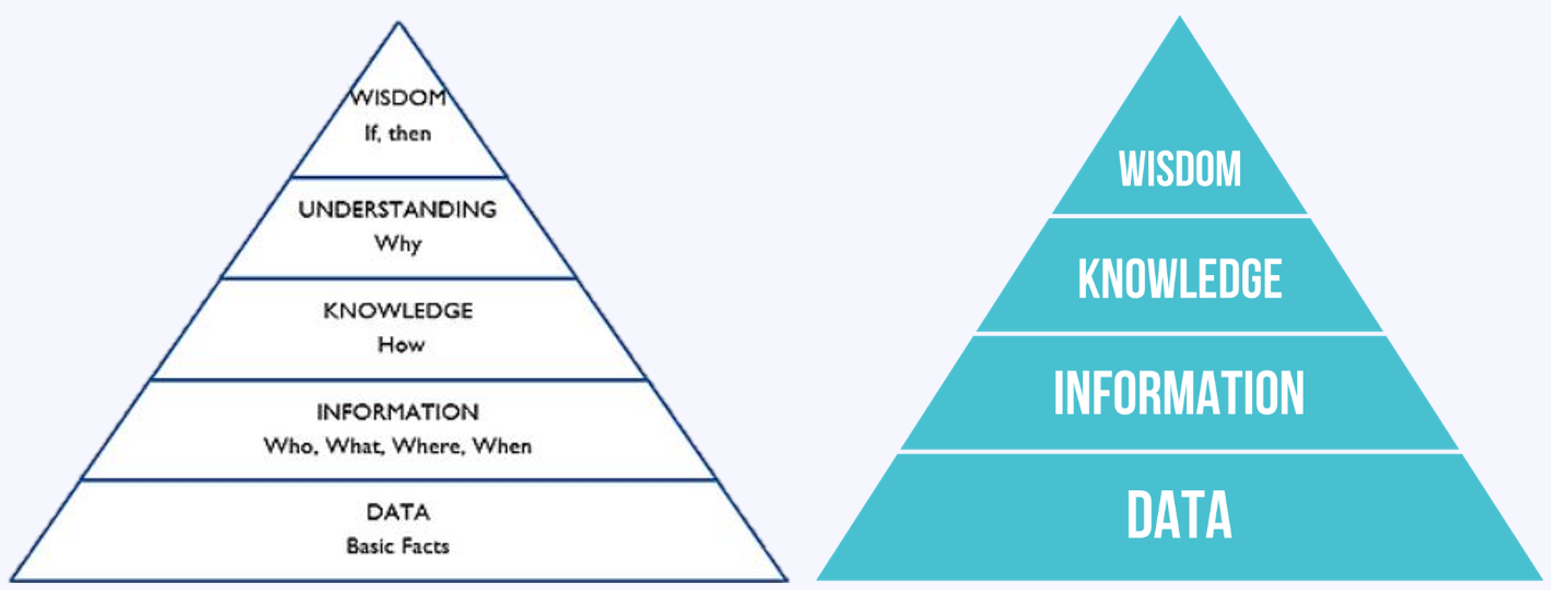

هرم دانش DIKW (داده-اطلاعات-دانش-خِرَد) – ویکیپدیا هرم دانش DIKUW (داده-اطلاعات-دانش-درک-خِرَد) – فوربس

هرم دانش DIKW (داده-اطلاعات-دانش-خِرَد) – ویکیپدیا هرم دانش DIKUW (داده-اطلاعات-دانش-درک-خِرَد) – فوربس